Eine Schritt-für-Schritt-Anleitung

Mit der Version 3.2 erweitert Meta seine Llama-Modellreihe um beeindruckende visuelle Fähigkeiten. In Zusammenarbeit mit Ollama kannst du Llama 3.2 Vision so nutzen, dass es Bildinhalte interpretieren und beschreiben kann – eine Funktion, die für alle möglichen Anwendungen von der Bildanalyse bis zur Erstellung von interaktiven KI-gestützten Bildinhalten nützlich ist. Dank Ollama lässt sich dieses leistungsstarke Modell direkt auf dem eigenen Rechner einfach betreiben, ohne dass eine ständige Internetverbindung erforderlich ist. In diesem Artikel zeigen wir Schritt für Schritt, wie du Ollama und Llama 3.2 Vision auf deinem Rechner installieren und für Bildinterpretationsaufgaben einsetzen kannst.

Installation von Ollama und Llama 3.2 Vision

1. Voraussetzungen prüfen

Stelle sicher, dass dein System die Mindestanforderungen für die Ausführung großer KI-Modelle erfüllt. Ein leistungsstarker Computer mit genügend RAM, VRAM und freiem Speicherplatz ist empfehlenswert.

Hinweis: Llama 3.2 Vision 11B benötigt mindestens 8 GB VRAM, und das 90B-Modell benötigt mindestens 64 GB VRAM!

2. Ollama herunterladen und installieren

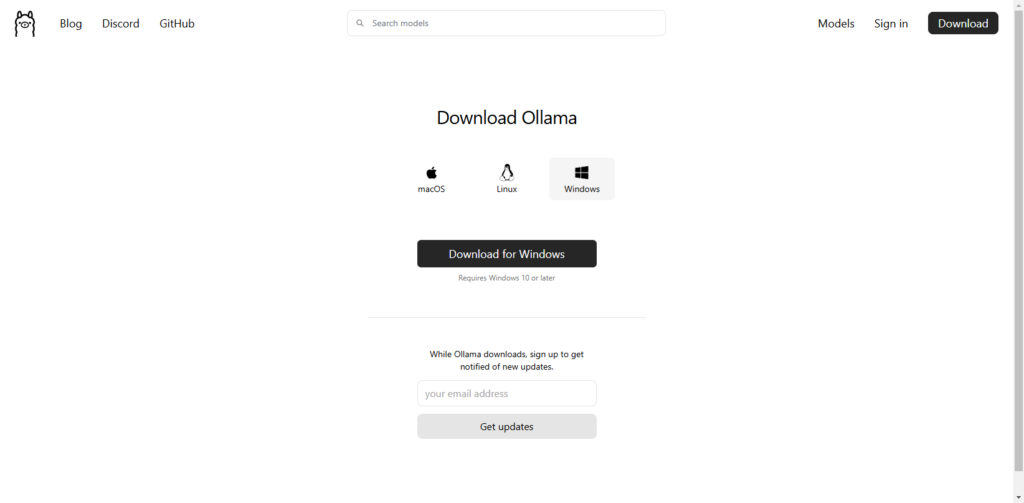

Lade Ollama von der offiziellen Ollama-Website herunter.

Die Installationsdatei OllamaSetup.exe für Windows ist etwa 765 MB groß.

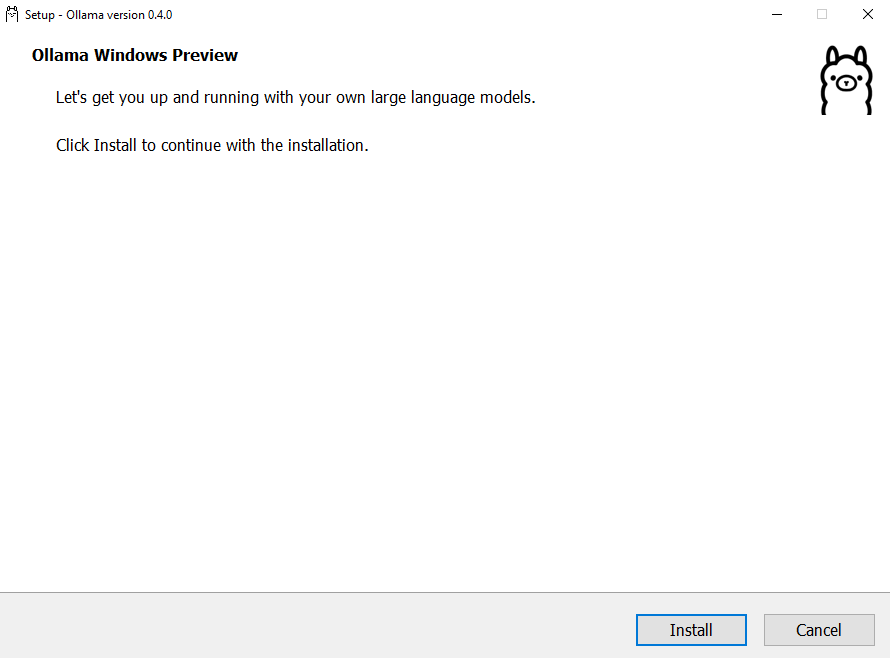

3. Ollama installieren

Folgen Sie den Installationsanweisungen für Ihr Betriebssystem (z. B. macOS, Windows, oder Linux).

Öffne z. B. die OllamaSetup.exe für Windows und folge den Anweisungen. Die Installation erfolgt in wenigen Klicks.

Die Installation ist unkompliziert. Solltest du dennoch Fragen haben, melde dich einfach bei uns – wir helfen dir gerne weiter 🤜🤛

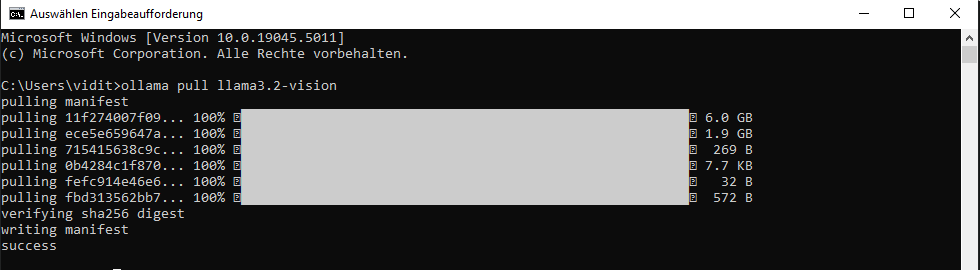

4. Llama 3.2 Vision-Modell herunterladen

Öffne nach der Installation von Ollama das Terminal (bei Windows die Eingabeaufforderung oder PowerShell) und führe diesen Befehl aus:

ollama pull llama3.2-visionDieser Befehl lädt das Modell lokal herunter und speichert es auf deinem System.

Das Llama 3.2 Vision 11B Modell benötigt etwa 8 GB Festplattenspeicher und mindestens 8 GB VRAM auf deiner Grafikkarte.

Für die größere 90B-Version des Modells, verwende:

ollama pull llama3.2-vision:90b5. Llama 3.2 Vision starten

Starte das Modell mit folgendem Befehl:

ollama run llama3.2-visionNun ist das Modell bereit, Anfragen entgegenzunehmen und Bilddaten zu verarbeiten.

6. Bildbeschreibung erstellen

Um die Funktionsweise des Modells zu demonstrieren, lassen sich verschiedene Anwendungsfälle ausprobieren.

Ziehe ein Bild in das Terminalfenster, um das Bild analysieren zu lassen.

INPUT:

>>> F:\AIFactum\AIFactum-KI-Tool-Ollama-ScreenShot.png

Added image 'F:\AIFactum\AIFactum-KI-Tool-Ollama-ScreenShot.png'OUTPUT:

The image shows a screenshot of the Ollama website, which is a platform for creating and sharing large language

models. The website has a clean and modern design, with a white background and black text.

* **Header**

* The header includes links to various pages on the website.

* Blog

* Discord

* GitHub

* Models

* Sign in

* A search bar is located at the top of the page, allowing users to search for specific models or keywords.

* **Main Content**

* The main content area features a prominent call-to-action (CTA) button that reads "Get up and running with

large language models."

* Below the CTA button, there is a brief description of what Ollama offers: "Run Llama 3.2, Phi 3, Mistral,

Gemma 2, and other models. Customize and create your own."

* **Footer**

* The footer contains links to various resources and tools related to large language models.

* Docs

* GitHub

* Discord (Twitter)

* Meetups

Overall, the website appears to be well-designed and user-friendly, making it easy for users to navigate and find

what they're looking for. The prominent CTA button encourages users to take action and start using Ollama's services.Das Modell verarbeitet das Bild und gibt eine detaillierte Beschreibung des Inhalts zurück. Natürlich kannst du anschließend weitere Fragen stellen, um noch mehr Informationen zu erhalten.

INPUT:

>>> auf Deutsch bitte :)OUTPUT:

Hier ist der Text auf Deutsch:

* **Header**

* Der Header enthält Links zu verschiedenen Seiten auf der Website.

* Blog

* Discord

* GitHub

* Models

* Sign in

* Ein Suchfeld befindet sich am oberen Ende der Seite, sodass Benutzer nach bestimmten Modellen oder

Schlüsselwörtern suchen können.

* **Hauptinhalt**

* Der Hauptinhaltsbereich zeigt ein prominentes "Get up and running with large language

models"-Schaltfläche.

* Darunter befindet sich eine kurze Beschreibung dessen, was Ollama anzubieten hat:

"Run Llama 3.2, Phi 3, Mistral, Gemma 2 und andere Modelle. Passen Sie sie an oder erstellen Sie Ihre eigenen."

* **Fußzeile**

* Die Fußzeile enthält Links zu verschiedenen Ressourcen und Tools im Zusammenhang mit großen

Sprachmodellen.

* Docs

* GitHub

* Discord (Twitter)

* Meetups

Zusammenfassend sieht die Website gut gestaltet und benutzerfreundlich aus, sodass Benutzer leicht navigieren und

das gesuchte finden können. Die prominente Schaltfläche ermutigt Benutzer, Aktionen einzuleiten und Ollamas Dienste zu nutzen.Beispiele zur Verwendung von Llama 3.2 Vision

Objekterkennung und Textanalyse

Llama 3.2 Vision ist in der Lage, Objekte in Bildern zu erkennen und zu benennen. Für Nutzer, die in der Fotografie oder im Design arbeiten, kann dies eine hilfreiche Funktion sein, um Bildinhalte besser zu katalogisieren.

Texterkennung (OCR)

Integriere Bilder mit Text, wie z. B. Dokumente oder Straßenschilder, und lasse das Modell die Textinhalte interpretieren und extrahieren.

Die Kombination aus Llama 3.2 Vision und Ollama eröffnet neue Möglichkeiten für die Bildanalyse und maschinelles Sehen auf dem eigenen Rechner. Besonders für Anwender, die ohne Cloud-Lösung arbeiten möchten, bietet Ollama eine benutzerfreundliche Lösung, die KI-Bildanalyse direkt lokal auszuführen. Dies ist nicht nur sicherer in Bezug auf Datenschutz, sondern auch praktischer für anspruchsvolle Anwendungen. Egal ob im Bereich Design, Fotografie oder Dokumentenverwaltung, Llama 3.2 Vision stellt eine wertvolle Möglichkeit dar, die sich leicht in verschiedene Workflows integrieren lässt.

Unser Fazit: Wenn KI Bilder verstehen lernt

Puh, da tut sich echt was Spannendes in der KI-Welt! Die Möglichkeit, Bilder direkt auf dem eigenen Rechner analysieren zu können – ohne dass alles in die Cloud wandern muss – ist schon ein echter Gamechanger. Gerade für alle, die mit sensiblen Daten arbeiten oder einfach ihre Privatsphäre schätzen, ist das ein echter Pluspunkt.

Ob nun Fotos katalogisieren, Texte aus Dokumenten ziehen oder einfach mal schauen, was auf den Bildern so alles zu sehen ist – die lokalen KI-Modelle machen’s möglich. Und das Beste: Man braucht dafür nicht mal eine Internetverbindung!

Klar, die Technik entwickelt sich rasend schnell weiter, und was heute top ist, könnte morgen schon überholt sein. Also: Falls du weitere spannende Tools oder neue Modelle auf dem Schirm hast, die einen Testlauf verdienen – immer her damit! Wir bleiben für dich am Ball und checken aus, was wirklich taugt.